La fin des colonies françaises

« Les colonies sont faites pour être perdues »

~ Henry de Montherlant

Les colonies étaient une des fiertés de la France. Présent sur quasiment tous les continents, de nombreux leaders politiques ont eu du mal à leur accorder leur indépendance après la seconde guerre mondiale. Cela s’est relativement bien passé dans l’ensemble des pays sauf comme on le sait tous en Indochine puis en Algérie juste après. Comme s’est passé la fin des colonies en France ? Réponse dans ce podcast de 2000 ans d’histoire.

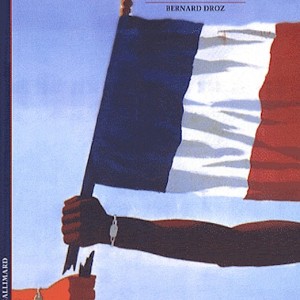

Découvrez également le livre La fin des colonies françaises.

Image du livre "La fin des colonies françaises"

Bernard Droz

Les derniers articles par Bernard Droz (tout voir)

- La fin des colonies françaises - 01/07/2014

(4,04 sur 5)

(4,04 sur 5)